LLaMA-Adapter

LLaMA-Adapter: Enhancing Transformer Fine-Tuning with Zero Initialization

元数据:

分类:机器学习

标签:Adapter Tuning, Transformer, LLaMA, 微调

日期:2025年4月12日

核心观点总结

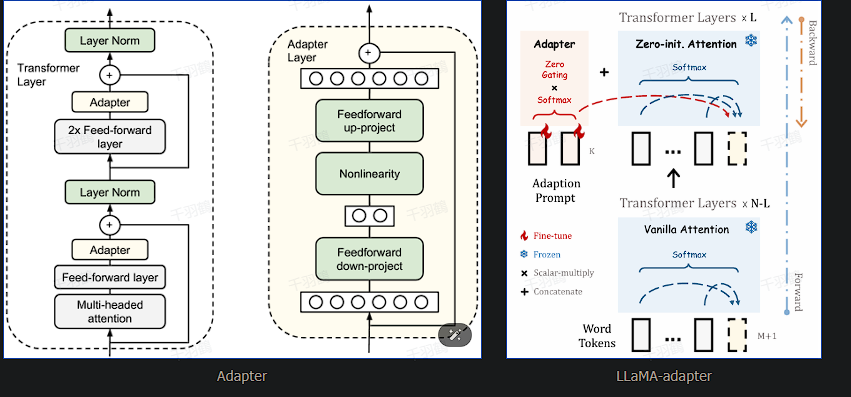

在机器学习中,Adapter Tuning是一种通过引入额外模块来适配下游任务的方法。其特点是通过在每一层的Transformer中加入Adapter模块进行微调,虽然这种方法在训练和推理阶段增加了成本,但它提供了一种灵活的模型调整方式。

LLaMA-Adapter是对传统Adapter和Prefix Tuning方法的改进。其主要创新是通过零初始化的注意力机制和门控机制来解决随机初始化可能损害预训练知识的问题。这种改进使得微调过程更加稳定,并减少性能损失。

重点段落与数据

-

Adapter Tuning的核心思想:

- Adapter Tuning通过在Transformer层中加入额外模块进行微调。

- 优点是适配性强,缺点是增加了训练和推理成本。

-

LLaMA-Adapter的创新:

- 通过零初始化注意力机制和门控机制改善微调稳定性。

- 仅修改深层的L个Transformer层,减少对模型整体结构的影响。

-

技术术语转换:

- Transformer:一种用于处理序列数据的神经网络架构。

- 微调:在预训练模型基础上进行小规模调整以适应特定任务。

操作步骤

✅ 引入零初始化的注意力机制以保持预训练知识。

⚠ 仅修改深层的L个Transformer层,避免对整个模型造成不必要的变化。

❗ 使用门控机制进一步稳定微调过程。

常见错误

⚠ 随机初始化可能导致预训练知识损害,需谨慎选择初始化方法。

💡启发点

- 零初始化策略在保持预训练知识方面表现优异,值得在其他领域探索应用。

行动清单

- 研究零初始化策略在其他机器学习模型中的应用潜力。

- 测试不同门控机制对微调稳定性的影响。

- 评估LLaMA-Adapter在不同下游任务中的性能表现。

原始出处: 机器学习技术文档

以上内容为基于原文的博客笔记总结,旨在为读者提供清晰的技术理解和应用指导。